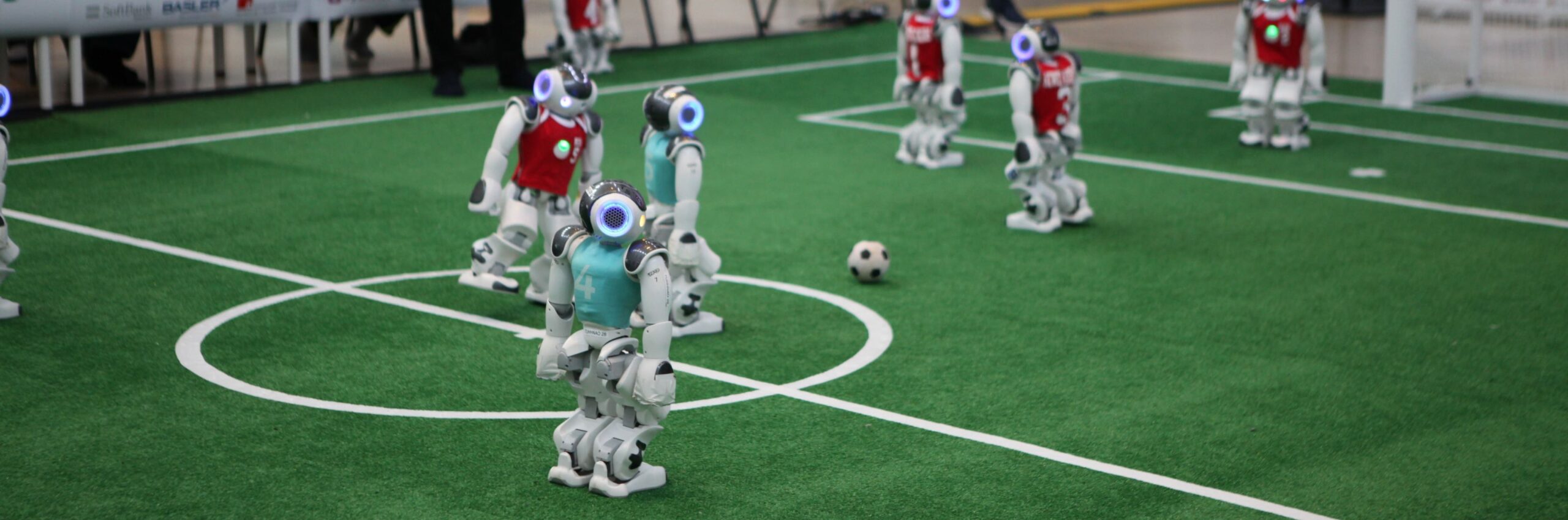

Die deutsche und internationale Forschungsgemeinschaft der

RoboCup SPL https://spl.robocup.org/

trifft sich jährlich in der Adventszeit zum Informationsaustausch; seit Corona online, via discord.

Auch für 2022 lädt das Team HULKS ein:

Liebe Mit-Robocuppers,

bald ist es Zeit für die vRoHOW!

Die Inhalte, d.h. Vorträge, Präsentationen und Workshops, finden zwischen dem 2. und 4. Dezember statt.

Alle weiteren Informationen und den Zeitplan gibt es unter rohow.de

Wir freuen uns auf Sie.

Über vRoHOW

Die RoHOW ist eine Bildungs- und Networking-Veranstaltung der Technischen Universität Hamburg-Harburg (TUHH) mit Studenten und Wissenschaftlern aus aller Welt, die in der Forschung an humanoiden Robotern tätig sind.

Teams der Standard Platform League sind eingeladen, ihre Arbeit in Vorträgen, Lightning Talks oder Workshops zu präsentieren. Organisiert wird die RoHOW von Studenten des RoboCup-Teams, den HULKs der TUHH.

Übersetzt mit www.DeepL.com/Translator (kostenlose Version) Weiterlesen